Data Science and Massive Data Analysis

Vous trouverez ci-dessous mes notes concernant l’événement : « Data Science and Massive Data Analysis »

En cette journée du 12 juin 2014 s’est tenu un événement autour de la Data Science organisé par Laurent Najman (ESIEE Paris) et Guillaume Obozinski (Ecole des Ponts – ParisTech). Tout au long de la journée, nous avons pu assister aux présentations de différents intervenants de cette spécialité.

Le premier «talk » a été tenu par Yann LeCun, directeur de la recherche en Intelligence Artificielle à Facebook et pionnier dans le domaine du Machine Learning.

« Make Smartphones Smarter » illustre la volonté de Facebook de toujours continuer à tirer profit du Big Data.

Yann LeCun a discuté des résultats atteignables grâce au « Deep Learning », ce dernier étant inspiré du cerveau humain, des informations transmises entre neurones et permettant des phénomènes tels que la reconnaissance d’une personne.

Ces techniques visent ainsi à créer des programmes capables d’apprendre des « patterns », pour classifier des chiffres par exemple.

Ce n’est pas la première fois que la biologie sert de base à l’élaboration d’une technique scientifique. En effet, l’avion a été inventé afin de reproduire la capacité de voler des oiseaux. Mais il ne s’agit pas uniquement d’essayer de copier la biologie, il faut comprendre le phénomène dans son ensemble si l’on ne veut pas comme résultat un avion qui a l’impulsion initiale mais qui est incapable de se maintenir dans les airs une fois « lancé ».

Yann LeCun a ensuite présenté des applications du Machine Learning permettant la localisation automatique d’objets ou de personnes dans une image.

Il a également fait une démonstration sur ordinateur d’un programme donnant comme résultat un certain nombre de tags pour l’objet présenté à la caméra. Si l’un des tags correspond effectivement à l’image, l’opération est considérée comme un succès.

Un second « talk » a été tenu par Nicolas Leroux, Scientific Program Manager (R&D) à Criteo. Il a présenté l’activité de Criteo, notamment le système d’enchère en temps réel (RTB) qui permet d’enchérir en temps réel sur un emplacement publicitaire en ligne.

Le Machine Learning est utilisé afin de prédire la probabilité qu’un utilisateur aura de cliquer sur la bannière qui lui est présentée, ou plus encore de prédire si le clic sera suivi ou non d’un achat. La difficulté vient du fait qu’il faut être capable d’effectuer cette prédiction dans un laps de temps très court (quelques millisecondes). Pour améliorer le modèle, il faut ainsi le complexifier tout en veillant à ne pas augmenter le temps nécessaire à la prédiction. Des techniques de réduction de dimensionnalité telles que le Hashing sont utilisées.

Afin de savoir quels produits mettre en avant, Criteo a dû mettre en place des algorithmes de recommandation. Toujours dans un soucis de prédire très rapidement, une présélection de produits peut être faite en tenant que de la popularité par exemple.

Un autre « talk » a été tenu par Cédric Archambeau, Senior Scientist à Amazon.

La Data Science aide Amazon à découvrir différents patterns, différentes tendances, à mieux comprendre les consommateurs.

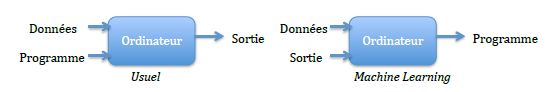

Il a présenté le Machine Learning comme suit :

Il a énoncé les points suivants :

- Plus de 20 millions de produits.

- Les produits sont différents / similaires suivant plusieurs critères.

- Les recommandations ont une « durée de vie » qui peut varier selon les produits.

Il a également énoncé des points relatifs au Machine Learning :

- Avoir plus de données peut permettre d’être meilleur que des modèles poussés.

- Des modèles recherchés peuvent ne pas être scalables.

- Beaucoup de données ne signifie pas qu’il n’y a pas de biais.

- Un modèle simple ne signifie pas qu’il y a peu de paramètres.

- Beaucoup de données ne signifie pas qu’il n’y a pas de données manquantes.

D’autres « talks » ont eu lieu :

- Lorenzo Rosazco, « Early stopping regularization »

- Nicolas Usunier, « Learning Structure-Preserving Vector Representations of Objects from Open-Domain Relational Data »

- Emilie Chouzenoux, « Proximal methods: tools for solving inverse problems on a large scale »